Көп айтпашы: нейросеттер менен байланышта сактык эрежелери

Жасалма интеллект күнүмдүк жашоодо эле эмес, бизнесте да колдонулуп жатат. Анткенмен, чоң маалыматтар менен иштеген башка технологиялардай эле, ал айрым тобокелдиктерди алып келиши мүмкүн. Эң биринчи жагы, бул маалыматтын коопсуздугуна тиешелүү. Нейросеттер менен өз ара иштешүүдө эмнелерге көңүл коюу керек, суюлтууларды болтурбоо үчүн: Дмитрий Крюков, «МТС Линк» компаниясынын машина менен үйрөнүү бөлүмүнүн башчысы айтып жатат.

Конфиденциалдуу маалыматтар: бул эмне

Алгач, конфиденциалдуу маалыматтардын эмне экенин аныктайлы. Бул маалыматтар, ачыкка чыгуусу физикалык жана юридикалык жактарга зыян тийгизиши мүмкүн. Аларга төмөнкүлөр кирет:

персоналдык (паспорт маалыматтары, СНИЛС, медициналык маалымат, киреше тууралуу маалымат), ошондой эле байланыш маалыматтары, мисалы, телефон номерлери жана электрондук почта даректери;корпоративдик (ички процесстер, аналитика, кардарлар жана кызматкерлер жөнүндө маалымат, юридикалык тобокелдиктер);соода сырлары (техникалык сырлар, стратегикалык активдер, рыноктук инсайттар жана финансылык отчеттуулук);мамлекеттик (классификацияланган) — буларга кийинчерээк токтоло турмакчыбыз.

Бул маалыматтарды коргоо мыйзам тарабынан жөнгө салынат.

Ушул учурдагы коомдо көпчүлүк адамдар жеке маалыматты коргоо жана суюлтуулардан кийинки кесепеттерин түшүнүшөт. Корпорациялар, өз тараптан, маалыматтардын коопсуздугун камсыздоо үчүн системаларды иштеп чыгышат. Ошентип, суроо туулат: конфиденциалдуу маалыматтар жасалма интеллекттин колуна кантип туш болушу мүмкүн?

Жеке маалыматтын нейросеттерге кирүү жолдору

Алгач, сөз ачык ИИ моделдери жөнүндө, мисалы, ChatGPT (OpenAI), Claude (Anthropic), DeepSeek, Midjourney, Gemini (Google), Copilot (Microsoft) ж.б. тууралуу болууда.

Бул системалар чоң көлөмдөгү маалыматтарда, ачык булактардан: веб-сайттар, социалдык тармактар, макалалар жана документтер, сүрөттөр жана видеолор аркылуу үйрөнүшөт. Ошондой эле, иштеп чыгуучулар лицензияланган маалымат жыйынтыктарын сатып алышы мүмкүн. Специальдуу моделдер так тармактарда, мисалы, медицина же юриспруденция боюнча, үйрөнүүгө мүмкүнчүлүк алышы мүмкүн. Персоналдык маалыматтар үйрөнүү жыйынтыктарында кээде кездеше алат, жада калса анонимдештирилсе да, анткени ИИ адамдардын идентификациясын параметрлерди талдоо аркылуу калыбына келтире алат.

Экинчи жолу — колдонучулар өздөрү ачык ИИ кызматтары менен байланышып, маалыматтарын беришет:

мисалы, документтерди шайкеш келтирүү үчүн жүктөшөт, резюмелерди жиберишет же грамоталыкты текшерүү үчүн суроолор беришет;аяшчаржындар, телефон номерлери жана даректерин «Яндекс» компаниясынан «Алиса» же Mail.ruдан «Маруся» сыяктуу үн жардамчыларга айтышат;банктардагы карталарынын номерлерин цифралык жардамчыга өткөрүшөт;медициналык чат-ботторго (мисалы, Cleverbotsтан) жеке маалыматтарды киргизишет;абдан белгилүү котормо кызматтары аркылуу маалымат берүү;кызматтарга туташканда жеке жана корпоративдик почталык ящиктерине кирүү мүмкүнчүлүгүн берүүгө.

«Яндекс Диск», «Google Диск» жана OneDrive сыяктууPOPULAR булуттук кызматтар дагы ИИ алгоритмдерин колдонушат. Алар тексттер жана сүрөттөрдү оптикалык тааныштыруу (OCR) технологияларын документтерди жана файлдарды издөө үчүн колдонушат. Бул кызматтарда чоң көлөмдөгү жеке жана корпоративдик маалымат сакталат, бул аларга ушул маалыматтарга кирүү мүмкүнчүлүгүн берет.

Маалыматтарды сактык менен бөлүшүүнүн жолдору

Маалыматтарды ИИ менен бөлүшүү коопсуздук үчүн ар дайым коркунучтуу болбостугу маанилүү. Нейросеттер өзүнүн уникалдуу мүмкүнчүлүктөрү менен популярдуулукка ээ болууда, жана алардын колдонулушунан баш тартуу туура эмес.

Алар чоң көлөмдөгү маалыматтарды иштеп, көптөгөн процесстерди автоматташтырып, текст жана визуалдык контентти тез генерирлеп, тил тосмолорун жоёт жана адамдык каталардын санын минималдаштырууга жөндөмдүү. Муну менен катар, алар адамдарга жогорку сапаттагы чечимдерди берүү үчүн дайыма үйрөнүп турушат.

Эң популярдуу ИИ кызматтар бекер жеткиликтүү. Бирок алардын иштеп чыгуучулары чыгашаны азыраак так жолдор менен алууга аракет кылышат:

мисалы, маалыматтарды андан аркы үйрөнүү үчүн (анонимдештирүү менен) колдонуп, бул өзү булак болот;агрегирленген маалыматтарды үчүнчү жактарга белгилүү реклама үчүн сатуу (буларды көбүнчө кичинекей стартаптар жасаат);түздөн-түз функцияларды кеңейтүү үчүн акча төлөөнү талап кылган платформадагы жазылууларды сунуштоо;өз технологияларын лицензиялап, нейросеттерди башка тиркемелерге интеграциялоого уруксат берүү;кройдфандинг, фандрайзинг жана инвесторлордун финансирлөөсүн пайдаланып.

Маанилүү жагы, ашыкча маалыматтарды жыйынтыктаган ачык маалымат боюнча үйрөнгөн нейросеттер конфиденциалдуу жана коомдук маалыматтарды айырмалоо жөндөмүнө ээ эмес — бул колдонуучулардын милдети. Чоң платформалар, мисалы, OpenAI же Claude, маалыматты өткөрүп берүүдөн жана репутациялык тобокелдиктерден качып, маалыматтын коопсуздугу биринчи кезекте өздөрүнүн колдонуучуларына байланыштуу.

Нейросеттин коопсуздугун кантип аныктоого болот

Көптөгөн ачык ИИ моделдери булулық кызматтар аркылуу иштешет, бул алардын жалпы ысыклоосун масштабдалат. Маалыматтар маалыматты иштеп чыгуучу борборлордун серверлеринде сакталат. Ошентип, нейросеттерге жөнөтүлгөн маалыматтар (суроолор, файлдар) жеткиликтүү болууда, буларды гана иштеп чыгуучулар эмес, ошондой эле булулық кызмат көрсөтүчүлөр да ала алышат. Мындан тышкары, мамлекеттик органдар бул маалыматтарга сот чечими аркылуу кирүү мүмкүнчүлүгүнө ээ болушат. ДЦО (дерево обработки данных) ар кандай өлкөлөрдө болушу мүмкүн, бул аларды ар түрдүү юрисдикцияларга баш ийтүүгө мажбурлайт.

Одатта, ИИ негизинде иштеген кызматтар колдонуучулардан маалыматтарды иштеп чыгууга уруксат сурашат. Кээде колдонуучуларга галочка коюу керек, ал эми башка учурларда кызмат “колдонуучулар маалыматтарды иштеп чыгууга автоматтык түрдө макул болушат” деп билдиришет.

Ишенип жатып, ошондой эле коопсуздукка алып келген ИИ кызматын эске алуу үчүн кезектеги сунуштарды көзөмөлдөө керек:

Конфиденциалдуулукту талдоо — маалыматтарды колдонуу, кошумча үйрөнүү жана ушул опцияны өзү жоюу мүмкүнчүлүгү жөнүндө пункттар барбы, жокпу, текшерүү керек. Мисалы, ChatGPT программасында тарыхты жана чатомду эстеп калууга жоюу мүмкүнчүлүгү бар. Китайда терең изилдөө жана Copilot сыяктуу корпоративдик жазылуулар маалыматтарды жыйноону токтотуу мүмкүнчүлүгүн берет. Gemini жана башка системаларда маалыматтар көбүнчө моделди жакшыртуу үчүн колдонулат.

ChatGPT колдонуучунун кабинен: маалыматтарды кайра үйрөнүү үчүн токтотуп туруу. Булак: «МТС Линк» маалымат кызматы

ИИ кызматтары маалыматтарды анонимдештирүүгө мүмкүндүк бар-болбосун текшериңиз. Мындай коргоону колдонуп жаткан булактар менен маалымат алуунун салыштырмалуу коопсуз экени эсептелет. Бирок мындай нерсенин болгонуна текшерүү көп учурда мүмкүн эмес. Популярдуу нейросеттердин аналогдору же документтер менен резюмелерди даярдоо үчүн программаларга катуу көңүл буруу керек.

Серверлер кайда жайгашкандыгын жана нейросеттин кимге таандык экенин билүүгө тырышыңыз: АКШ, ЕС, Кытай? Коргоо деңгээли аймакка жараша өзгөрүлүп турат. Кичине булут провайдерлери көп учурда суроолорго жооп берүүгө жана эрежелерди сактоого көңүл бөлүшпөйт, булеринин ачык-айкындуулугун азайтууга алып келет. Кээ бир өлкөлөрдө, мисалы, Азия жана Африканын бир бөлүгүндө, азга катуу жарыяланган жөнгө салуулар бар. Эл аралык сертификаттар провайдердин репутациясын көрсөтүп турат.

Кызмат жана суюлтуулар жөнүндө пикирлерди текшериңиз — суюлтуулардын белгилүү болушу. Бул көбүнчө адал эмес провайдерлерден келип чыгат же коргоо жок каналдар аркылуу. Бирок, ошондой эле текшерилген ИИ кызматтары максаттуу кибердуу кошулмалардын курмандыгы болушу мүмкүн.

Нейросеттер пайдаланучулары үчүн негизги тобокелдиктер

Ар бир жаңы технология сыяктуу эле, нейросеттер, миллион суроолорду иштеткенде, жаман жандардын сенарийлери болуп калат. Эл аралык финансылык Bobsguide аналитикалык агенттиги Cybercrime Trends 2025 (SoSafe) отчетун жарыялады, анын маалыматтарына ылайык 87% уюмдар ИИ'нын коркунучтарын билдиришкен. Ал эми 91% киберкоопсуздук адистери бул коркунучтардын акыркы үч жыл ичинде көп боло тургандыгын күтүүдө.

Фишинг, традициялык кызматтарда белгилүү нерсе, ИИ чөйрөсүнө да тиешеси бар. Уурулар популяциялык нейросеттерди (мисалы, фейк ChatGPT) козгоп, жасалма ИИ'ларды алдамчы каттар, сүрөттөр же видеолорду түзүү үчүн колдонушат. Аларды максаты — колдонуучулардын жеке маалыматтарын уурдоо же шантаж кылуу, анын ичинде компанияларды.

Алдамчылар болбоо үчүн, домен аттарын, электрондук почта даректерин жана жөнөтүүлөрдүн телефондорун текшериңиз; ошондой эле байланыштарды жана ырастоолорду тактык менен түркөө алыңыз.

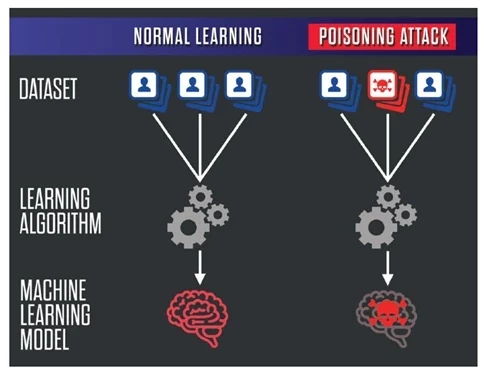

Машиналык үйрөнүү менен байланышкан коркунуч дагы бар — бул «маалыматтарды ууландыруу» (data poisoning). Бул процесс, анда коркунучтуу маалыматтар ИИ моделдеринин үйрөнүү комплекстери менен кошулат, бул натыйжаларын бузушу мүмкүн жана коопсуздукка кыйынчылыктарды келип чыгара алат, мисалы, жүздөрдү таанууда, диагноздорду туура эмес коюу жана медициналык дайындоолордо.

«Ууландырууга» каршы туруу үчүн, тааныш ыкмаларды (антивирус, отко тосук, тармактын көзөмөлү) колдонуу менен катар, маалыматтар базаларын аудит жүргүзүп, аномалияларды байкап жана маалыматтарды текшерүүнү жөндөө керек.

Нейросеттерди үйрөнүүдө маалыматтарды уулантуу процессин иллюстрациялаган диаграмма. Булак

Маалыматтын так эместиги — бул нейросеттердин өздөрүнүн каалаган, бирок мүмкүнчү касиети. Көптөгөн функционалдык параметрлерге карабастан, ИИ ката кетириши мүмкүн. Мисалы, ал бар болбосо маалыматтарды берет же кейирдик маалыматтарды так катары түшүнүүгө мүмкүн.

ИИ’дин жардамы менен иштерде «ишен, бирок текшер» принцибине ылайык болуу пайдалуу: ИИ маалыматтарды кайдан алганын жана өзүнүн тактыгына канчалык ишенет, жана текшериңиз. Текшерилген моделдер каталарды мойнуна алып, түшүндүрмөлөрдү берүүгө даяр. Бирок, эң жакшы ыкма — ИИ чечимдерин текшерүү үчүн эксперттердин көзөмөлүн колдонуу, айрыкча документтер жана отчеттор маанилүү учурда.

2023- жылы Samsung кызматкерлеринин чалгындоо коду ChatGPT’га кездешип калганына көзьюн гана маалыматнын суюлтуусу менен бет-ме бет болушту. Натижада компания генеративдик ИИ'ни өз түзмөктөрүндө колдонууга тыюу салды. Ошондой эле, Samsung’ка тиешеси бар маалыматтарды ChatGPT’га киргизүүгө тыюу салды.

Ошондой эле, ушул жылы OpenAI ChatGPT колдонуучуларынын маалыматтарыны суюлтуусу болганы жөнүндө маалымдашты. Ачык булактуу коддор боюнча ката кетирүү себептеринен улам, кээ бир колдонуучулар башка колдонуучулардын билдирүүлөрүн жана жеке маалыматтарын көрүшү мүмкүн эле. Жүйө бир нече саатка токтоп калды, көйгөй жоюлду, бирок бул инцидент колдонуучулар арасында коопсуздук боюнча башкалардан кайгыртууну жаратты.

Бизнести ИИ менен коопсуз байланышта болуу

Күнүмдүк жашоодо нейросеттер менен байланыштыктарачты өткөрүү аркылуу тобокелдиктерди азайтуу мүмкүнчүлүгү бар, бизнесте болсо, жагдай башкача.

Бул чөйрөдө, жеке маалыматтардан тышкары, соода сырлары, патенттер, стратегиялар жана техникалык детальдар бар. Маалыматтардын суюлтуулары жана аралаша кетүүлөр компанияларга чоң плактин финансылык жана репутациялык зыяндарды алып келиши мүмкүн. Коомдук булуттук нейросеттер API аркылуу интеграция жолунда коопсуздугуна миң подпарды талап кылат; муну туура же болбосо, мындай тобокелдиктердин акылмандыгы шектүү.

Анткенмен, бизнестеги ИИ’дин колдонулушунан арылуу туура эмес. Корпоративдик булуттук нейросеттер жардамга келет. Алар процесстерди жөнөкөйлөтүү менен катар, компаниялар үчүн жогорку деңгээлдеги коопсуздукту камсыз кылат.

Бул кызматтар жогорулатылган коопсуздук чаралары жана кеңейтилген параметрлерди сунуш кылат:

Корпоративдик чечимдерде, компаниялар маалыматтарды ишкө тартууну көзөмөлдөшөт, ал эми ачык булуттук кызматтар маалыматтарды үчүнчү тараптарды өткөрүүгө мүмкүн. Корпоративдик форматта кирүүнү чектөө, маалыматтарды сактоо жана жок кылуу саясатын орнотуу, ошондой эле конфиденциалдуу маалыматтар менен иштөө үчүн сертификаттоо жөнөтмөлөрүн жөнгө салуу мүмкүнчүлүгү бар, бул ачык кызматтарда жок. Ачык алгоритмдер кол салууларга көбүрөөк уюлдук болуп эсептелет, ал эми корпоративдик чечимдер көбүрөөк коргоо камсыз кылат.

Корпоративдик булуттук нейросеттер, продукттардын негизинде, мисалы, Россиидеги NTechLab сыяктуу, жүз таануу жана Москвадагы шаардык камералар тармагы менен иштөөгө жардам берет, же алардын бардыгына жакшыраак интеграциялай алат. Мисалы, маалыматтарды башкаруу үчүн колдонулган Directum RX системасында жабдылган ИИ документийлер, каттар, контентти анализ кылуу жана тапшырга тыгыздыктарды анализдөө, жумшак процесс жаткан иштерди тез арада көрсөтүүгө жардам берет. «МТС Линк» экосистемасында ИИ резюмелер жана чалууларды жазууда, ошондой эле онлайн-жыйындардагы негизги учурларды көрсөткөн видеолорду жасоого жардам берет. Бул платформада виртуалдык жардамчы да интеграцияланган.

«МТС Линк» компаниясынын виртуалдык жардамчысы. Булак — «МТС Линк» маалымат кызматы

Корпоративдик булуттук нейросеттерден альтернативалык болуп self-hosted моделдерди жайгаштыруу саналат — коргоо деңгээлиңиз боюнча эң жакшы вариант. Бул компаниянын жабдууларында өзүнүн ИИ системаларын түзүүнү камтыйт. Бардык серверлер, функционалдар жана маалымат жыйынтыктары ичиндеги уюштурууда же локалдык жабдууларда иштелип чыгат; үчүнчү жактарга маалымат өткөрбөйт. Бул ыкмалары коопсуз, Бирок, инфраструктураны куруу жана керектөө үчүн чоң инвестицияларды талап кылат.

Жалпысынан, бизнестеги ИИ кызматтары иш процессин жана табигый операцияларды абдан жакшыртууга жардам берет. Алар клиенттер менен байланышты, онлайн жыйындар, маркетинг чечимдери жана башкалар боюнча көптөгөн чөйрөлөрдү камтышы мүмкүн. Мисалы, MTS AI видеону аналитика, үн синтезирлөө жана акылдуу алдын-ала болжолдоо боюнча проекттерди иштеп чыгат.

Обсудим?

Смотрите также: